Целые числа составляют важную часть математики и информатики. Они используются в различных вычислениях и алгоритмах. Однако, при работе с целыми числами на компьютере, возникает особая особенность - ограниченность представления чисел. Всякая цифра, которая может существовать в проводниках и логических элементах компьютера - это конечный символ (обозначение), но множество цифр, которое мы используем обычно - бесконечное. Потому его так и ограничивают, оставляя только множество числе дискретных чисел, представимых в памяти компьютера.

Причиной этой дискретности является конечный объем памяти компьютера и метод представления чисел. Целые числа на самом деле представлены в виде последовательности символов, называемых разрядами. Каждый разряд может принимать одно из 10 возможных значений (от 0 до 9), что соответствует десятичной системе исчисления. Но количество разрядов и, соответственно, количество возможных комбинаций ограничено.

Максимальное число, которое может быть представлено на компьютере, зависит от количества разрядов используемых для хранения числа. Например, если используются 8 разрядов, то количество возможных комбинаций будет равно 2 в степени 8, то есть 256. Из этих 256 комбинаций, одна отводится под ноль, а остальные используются для представления положительных и отрицательных чисел. Таким образом, множество целых чисел, которое может быть представлено на компьютере с 8 разрядами, является дискретным и ограниченным.

Проблема непрерывности чисел

Эта проблема связана с тем, что компьютеры работают с ограниченным объемом памяти и имеют ограниченное количество бит, доступных для представления чисел. Например, для представления целых чисел обычно используется фиксированное число бит, например, 32 или 64 бита.

Такое ограничение приводит к тому, что не все числа могут быть представлены точно. Например, при использовании 32-битных чисел, максимальное представимое число будет 2^31 - 1, а минимальное - -2^31. Любое число, которое выходит за пределы этого диапазона, будет округляться или обрезаться до ближайшего представимого числа.

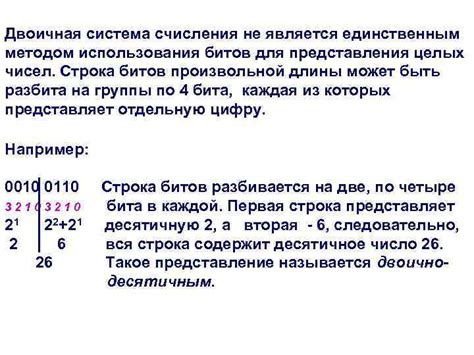

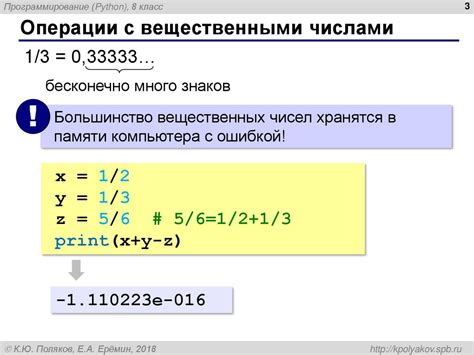

Также следует отметить, что компьютеры представляют числа в двоичной системе счисления, в то время как мы обычно работаем с числами в десятичной системе. Таким образом, некоторые числа не могут быть представлены точно в двоичной форме и могут иметь погрешность при вычислениях.

Эта проблема непрерывности чисел в компьютерах является основной причиной необходимости проектирования и использования алгоритмов и структур данных, которые учитывают эту дискретность и обеспечивают правильные вычисления и операции с числами.

Целочисленные значения в памяти

Как известно, компьютерная память состоит из ячеек, каждая из которых способна хранить определенное количество информации. Для представления целых чисел в памяти используется формат, называемый двоичным представлением.

Двоичное представление чисел означает, что каждая цифра числа может быть только 0 или 1. Например, в двоичной системе число 5 представляется как 101.

Каждая ячейка памяти компьютера имеет определенную ширину, которая определяет максимальное количество битов, которые она может хранить. Например, 8-разрядная ячейка может хранить число от 0 до 255 включительно.

Таким образом, множество целых чисел, представимых в памяти компьютера, ограничено набором возможных комбинаций битов, которые можно записать в каждую ячейку памяти. Это означает, что между каждым целым числом, представленным в памяти, существует конечное число других целых чисел.

Из-за этой дискретности между некоторыми числами существует промежуток, в котором не находится ни одно другое целое число. Например, для 8-разрядной ячейки памяти, существует 256 возможных комбинаций битов, что означает, что между числами 0 и 1 существуют еще 254 числа, которые нельзя представить в этой ячейке.

Использование битов для представления чисел

Каждое целое число в компьютере представляется последовательностью бит. Длина этой последовательности определяет максимальное значение, которое может быть представлено. Например, если использовать последовательность из 8 бит, то можно представить значения от 0 до 255 (2^8).

Существует два основных типа представления целых чисел: беззнаковое и знаковое. В беззнаковом представлении все биты используются для представления самого числа. Например, при использовании 8-битного беззнакового представления, число 5 будет записано следующим образом: 00000101.

В знаковом представлении один бит используется для представления знака числа (положительное или отрицательное), а остальные биты - для представления значения. Например, при использовании знакового представления с 8 битами, число -5 будет записано в виде: 10000101 (первый бит - знак, остальные - значение).

Использование битов для представления чисел позволяет компьютеру эффективно хранить и обрабатывать целые числа. Однако, такой способ представления имеет определенные ограничения, связанные с максимальным размером представимых чисел и потерей точности при использовании знакового представления. Поэтому, при работе с большими числами или требовании высокой точности, обычно используются другие способы представления, такие как числа с плавающей запятой или большие целочисленные типы данных.

| Тип представления | Минимальное значение | Максимальное значение | Длина (в битах) |

|---|---|---|---|

| Беззнаковое | 0 | 2^(n-1) - 1 | n |

| Знаковое | -2^(n-1) | 2^(n-1) - 1 | n |

Необходимость дискретности в компьютерах

Причина, по которой компьютеры используют дискретное представление чисел, связана с ограниченными возможностями памяти и обработки информации. Компьютеры не могут представить бесконечное количество чисел, так как наша физическая реальность ограничена. Они должны выбрать определенные интервалы, в которых числа могут быть представлены.

Дискретность чисел в компьютерах также связана с ограничениями в аппаратуре. Электрические сигналы, которые представляют информацию в компьютерах, могут быть только в определенных состояниях, например "вкл" или "выкл". Это приводит к тому, что числа в компьютерах представляются как целые числа или числа с плавающей запятой с ограниченной точностью.

Дискретность чисел имеет и практическое значение. Она позволяет компьютерам эффективно обрабатывать информацию. Операции с дискретными числами могут выполняться быстрее и с меньшим количеством ресурсов, чем операции с непрерывными числами. Кроме того, дискретные числа легче представлять и хранить в памяти компьютера.

Таким образом, дискретность чисел является неотъемлемым свойством компьютеров. Она обусловлена ограничениями физической реальности и аппаратурой компьютеров, а также обеспечивает эффективность обработки информации. Понимание этого позволяет лучше понять принципы работы компьютерных систем.

Ограниченная точность чисел в памяти

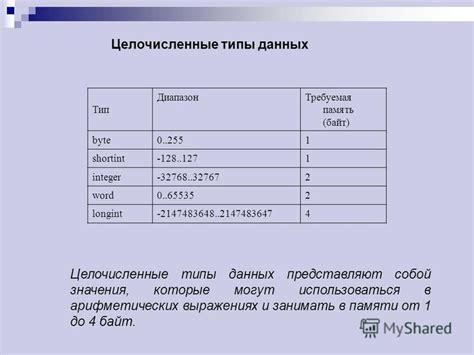

Наиболее распространенным типом чисел в компьютерах являются целочисленные числа, которые могут быть представлены без дробной части. Для представления целых чисел в памяти обычно используется тип данных "целое число" (integer), который может иметь различные размеры, такие как 8 бит, 16 бит, 32 бит или 64 бит. Каждый бит может хранить значение 0 или 1, что позволяет представлять числа в двоичной системе счисления.

Однако, из-за ограниченного количества битов, которые могут быть выделены для представления чисел, возникает ограничение на точность чисел в памяти. Например, целое число со знаком, представленное 8 битами (также известное как "byte"), может представлять числа от -128 до 127. Это означает, что только числа, попадающие в этот диапазон, могут быть точно представлены в памяти компьютера.

Кроме того, при выполнении математических операций с целыми числами, возможна потеря точности из-за ограничений размера чисел в памяти. Например, при сложении двух целых чисел, результат может выходить за пределы диапазона представимых чисел и приводить к переполнению или обрезанию значений. Это может привести к неправильным результатам и ошибкам в программном коде.

Таким образом, ограниченная точность чисел в памяти является одной из основных причин, по которым множество целых чисел, представимых в компьютере, является дискретным. Для работы с более точными числами требуется использование специальных типов данных или алгоритмов для повышения точности представления чисел.

Погрешности округления и представления

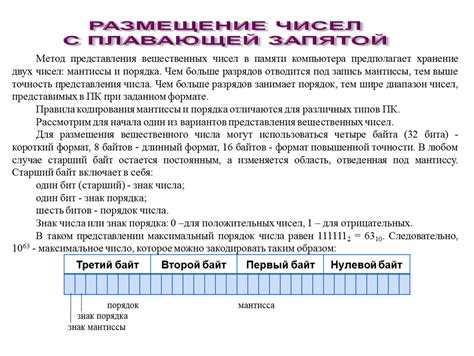

Целые числа, представленные в памяти компьютера, дискретно из-за погрешностей округления и представления вещественных чисел. У компьютера есть ограничения в представлении чисел с плавающей точкой, что приводит к потере точности при хранении и выполнении вычислений с этими числами.

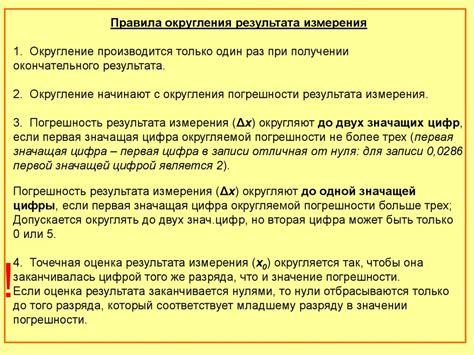

Округление – это процесс округления числа до ближайшего целого значения. Вещественные числа, которые не могут быть точно представлены в виде десятичной дроби с ограниченным числом цифр, округляются до ближайшего числа, которое можно точно представить в памяти компьютера.

Представление чисел в памяти компьютера также ограничено размером типа данных. Например, тип int в C++ занимает 4 байта и может представлять целые числа от -2147483648 до 2147483647. Если число, которое требуется представить, выходит за эти границы, то происходит циклическое переполнение и число оборачивается к противоположной границе.

При выполнении математических операций с вещественными числами также могут возникать погрешности округления. Например, при сложении двух чисел с ограниченной точностью, ошибка округления входных чисел складывается и может привести к непредсказуемым результатам.

Поэтому, хотя целые числа математически являются бесконечными и дискретными, их представление в памяти компьютера ограничено и подвержено погрешностям округления, что делает множество целых чисел, представимых в памяти компьютера, дискретным.

Алгоритмы и операции с дискретными числами

Алгоритмы и операции с дискретными числами в компьютерах играют важную роль в различных задачах. Например, можно использовать алгоритмы для нахождения наибольшего общего делителя двух чисел или для проверки числа на простоту. Операции с дискретными числами также широко применяются в математических вычислениях, играх, криптографии и других областях.

Одной из важных операций с дискретными числами является сложение. Для выполнения сложения двух чисел в компьютере используется алгоритм, основанный на сложении битов. При этом выполняются такие операции, как сложение двух битов, перенос разряда и обработка переполнения.

Кроме сложения, также выполняются операции вычитания, умножения и деления с дискретными числами. Для каждой из этих операций существуют соответствующие алгоритмы, которые определяют порядок выполнения определенных действий и обрабатывают возможные исключительные ситуации, такие как деление на ноль или переполнение при умножении.

Алгоритмы и операции с дискретными числами требуют точности и внимательности, поскольку компьютерное представление чисел может привести к неточным результатам. Например, при делении двух целых чисел может возникнуть ошибка округления или нужно быть внимательными при работе с очень большими или очень малыми числами, чтобы избежать потери точности.

Применение дискретной арифметики в компьютерных системах

Дискретная арифметика играет ключевую роль в функционировании компьютерных систем. Она отвечает за представление и обработку данных в цифровой форме, позволяя компьютерам проводить операции с числами.

Одной из основных причин дискретности чисел в компьютере является ограниченность количества битов, которые можно использовать для представления числа. В большинстве архитектур компьютеров число обычно представляется с использованием фиксированного количества битов, например, 32 или 64 бита. Это означает, что множество чисел, которые можно представить в компьютере, ограничено и дискретно.

Дискретная арифметика позволяет выполнять такие операции, как сложение, вычитание, умножение и деление чисел. Она позволяет компьютерным системам проводить точные математические операции с числами и получать точный результат. Однако, из-за дискретного характера представления чисел в компьютере, возможны ошибки округления и потеря точности, особенно при выполнении сложных вычислений или при использовании чисел с большим количеством разрядов.

Дискретная арифметика также применяется в компьютерных системах при работе с логическими значениями. Логические операции, такие как логическое И, логическое ИЛИ и логическое отрицание, выполняются с использованием булевых значений, которые могут принимать только два значения: истина или ложь. Эта дискретность позволяет компьютерам эффективно выполнять логические операции и принимать решения на основе логических условий.

Таким образом, дискретная арифметика является неотъемлемой частью работы компьютерных систем. Она обеспечивает возможность представления и обработки данных в цифровой форме, позволяет проводить точные математические операции и выполнять логические вычисления. Правильное понимание и использование дискретной арифметики является важным навыком для программистов и разработчиков компьютерных систем.